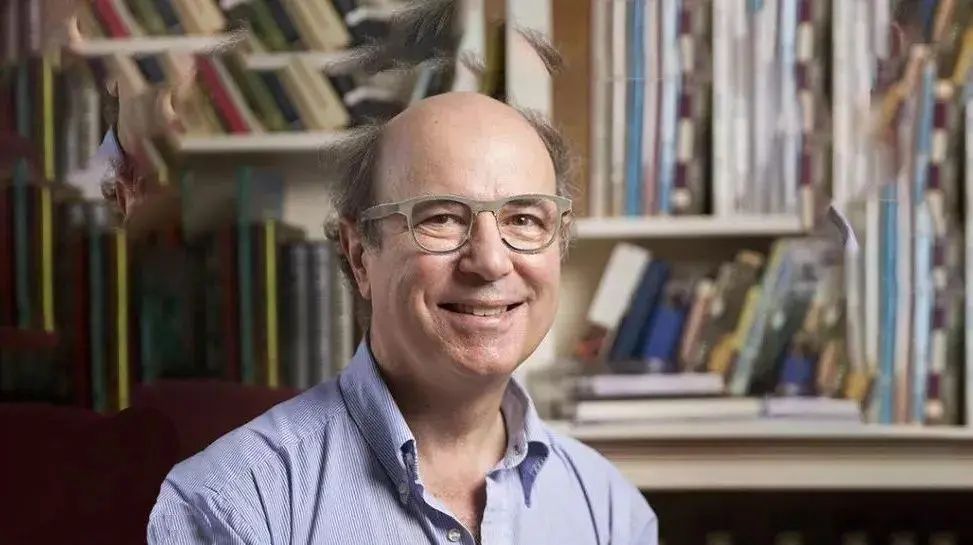

Frank Wilczek,美国理论物理学家,现任美国麻省理工学院物理系教授。在普林斯顿大学读博士期间,他和他的导师 David Gross 因发现了粒子物理的强相互作用理论中的“渐近自由”现象而获得2004年诺贝尔物理学奖。

墨子沙龙有幸邀请到Wliczek撰写 Wilczek's Multiverse 专栏。让我们一同走进Wilczek的“多元宇宙”,看看诺奖得主如何看待物理、量子、宇宙中所囊括的自然之谜。

这个美妙的问题极具挑战性。在20世纪50年代,弗兰克·罗森布拉特(Frank Rosenblatt)开创性地提出了“感知机”的概念,在当时引起了巨大的轰动。感知机实质上是麦库洛克-皮茨神经元的一种物理实现,但它拥有可调整的输入权重。比如:一个用于识别印刷字母“T”的感知机,在接收到不同方向且可能存在一些污点定模糊度的印刷字母数字化输入信号时(其中,印刷图像中的黑色像素被设定为1,其余部分则为0),能够对该印刷字母是否为“T”做出判断(1代表是,0代表否)。罗森布拉特提供了一个调整不同像素输入权重的详细规则,可以用来强化正确的识别和抑制错误的识别。因此,通过不断练习,感知机的识别成功率可以得到提高。

感知机成功学会了识别一些字母及某些特定模式。然而,在1969年,马文·明斯基(Marvin Minsky)和西摩·帕帕特(Seymour Papertt)共同撰写了一本极具影响力的书籍——《感知机》,他们在书中论证了,即便是面对稍微复杂一些的模式,感知机也显得力不从心。在这部极具影响的著作问世后,神经网络领域的研究陷入了多年的沉寂。

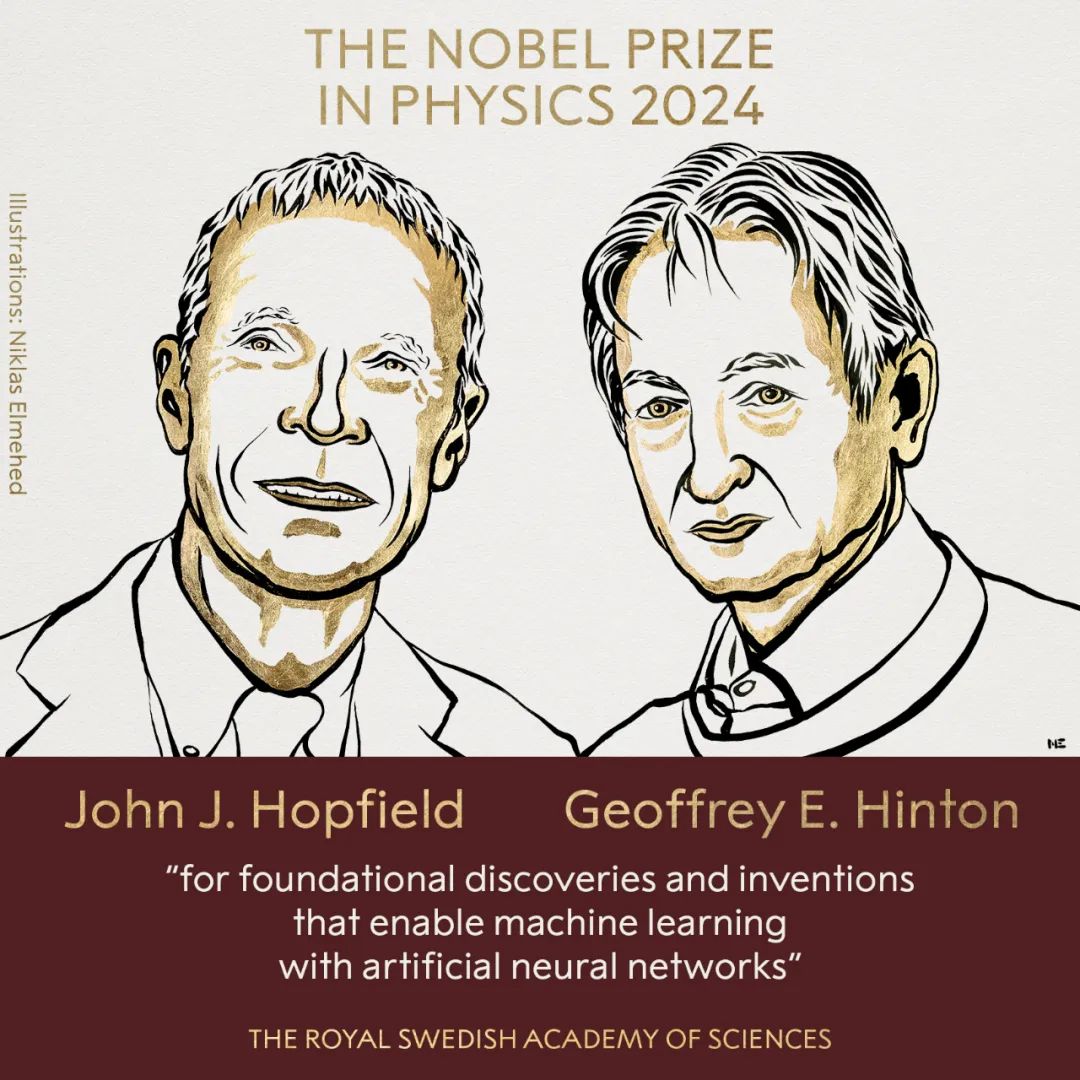

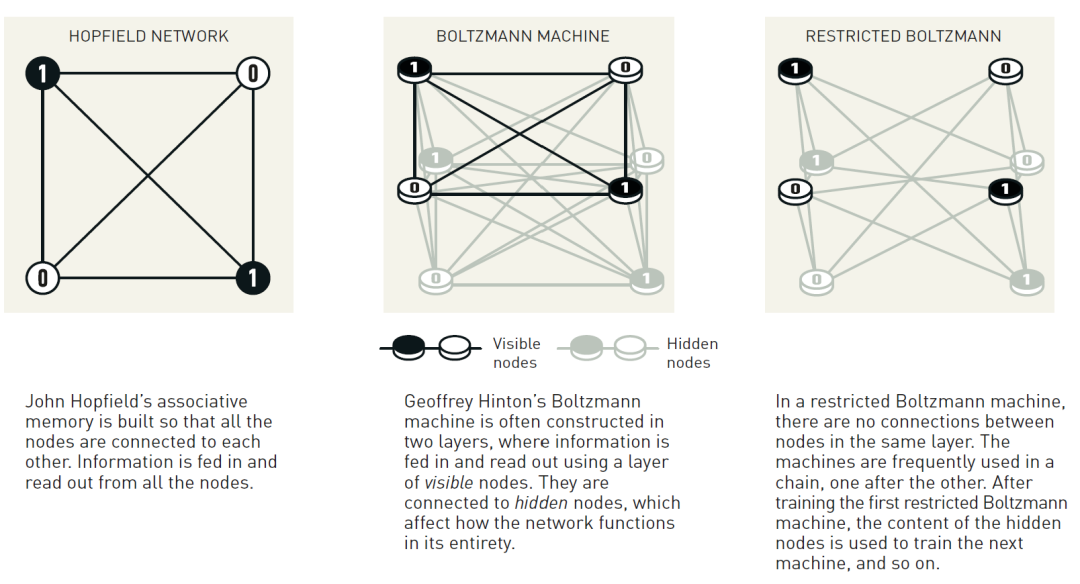

在20世纪80年代初,霍普菲尔德发表了一系列开创性论文,巧妙地将磁物理学的思想融入到神经网络的研究中,使这一领域重新焕发了生机。霍普菲尔德敏锐地洞察到固体中的自旋与神经网络中的神经元之间存在着深刻的数学相似性:一个自旋的“输入”是其相邻自旋的方向,而其“输出”则是自己的自旋方向;两个自旋“神经元”之间连接的强度,则可以类比于自旋间相互作用的强度。(简单起见,我们可以将自旋想象为一个只能够指上或者指下的系统,这样其输入和输出就可以用标准的0或1来表示。)这种类比启发了一种全新的构建神经网络的方法,使其能够“学习”更加普遍的模式。具体来说,通过精心设计自旋之间的相互作用,我们可以使得目标自旋分布模式所对应的能量达到最低。从数学上来看,这实现起来很容易。当我们输入的自旋配置与目标模式存在偏差时,系统会接受到一种“反馈”信号。这种反馈以力的方式作用在自旋上,促使它们自发地调整自身的指向,最终稳定在最符合目标模式的配置上。根据霍普菲尔德的理论,人们成功构建出一种联想记忆系统,它能够从模糊、不完整或嘈杂的记忆信息中,提取出准确的记忆内容。

与感知机相比较,霍普菲尔德的神经网络可以学习更多的模式。然而,这种神经网络面临着其他严重的局限性:一旦试图向网络中输入过多的模式,系统就会崩溃;此外,这些网络只能学习那些输入过的模式。

带着重新点燃的乐观情绪,一小群充满激情的科学家们勇敢地接受了设计功能更为强大、效率更高的机器学习神经网络的挑战。杰弗里·辛顿是其中的领军人物。在过去的几十年间,他为神经网络的发展做出了众多创新性贡献。辛顿的早期研究深受物理学的影响,这一点在他所命名的玻尔兹曼机和吉布斯机上可以明显看出。这两种网络正是受到19世纪统计力学先驱数学思想启发而构建的。在这些网络中,辛顿推广了霍普菲尔德的理论,赋予网络一种(概念上的)几何结构:将“传感器”神经元置于一侧,而“信号”神经元则置于另一侧,并使神经元之间的相互作用具有方向性。随后的改进则更多地源于实际应用中提高性能的需求,而不是基于现有的物理学(或生物学)原理。但可以预见,这些改进将在不久的将来对物理学和生物学领域产生深远的影响。无论如何,对于“深度学习”网络的发展,辛顿或许比其他任何人都做出了更多的贡献。正是他的贡献,使得机器学习在科学技术领域成为了一个极为强大且不可或缺的工具。

可以说,在它们需要的时候,人工神经网络利用了物理学;而反过来,神经网络也为物理研究带来了强大的助力。一个典型的例子就是分析高能加速器碰撞的数据,这一应用自20世纪90年代以来便已开始。在大型强子对撞机中,质子碰撞后通常会产生数十种不同的粒子。探测器会记录下这些粒子在时空中的轨迹、穿越物质时的能量变化、运动如何受磁场影响、不稳定的那些运动轨迹如何分叉成新的轨迹,以及其他相关的物理数据。然而,这些数据并无法直接揭示出这些粒子或粒子群中,究竟哪一个是K介子,或者哪些粒子是源于希格斯玻色子的衰变。为了从探测器记录的海量数据中识别出这些不同的粒子,物理学家需要借助人工智能神经网络的强大模式识别能力。毕竟,面对数万亿个复杂事件所生成的巨大数据量,人类的分析能力和耐心都显得极为有限。

更广泛地讲,神经网络是我们的绝佳合作者,它不但会从复杂数据中寻找规律,比如识别湍流中的涡旋,还会在海量数据中捞取那些引人注目的“针”,比如在外星智慧搜寻(SETI)项目中。值得一提的是,今年的诺贝尔化学奖就颁给了在蛋白质几何结构和设计领域的研究,而这项研究正是大量运用了神经网络技术。这很可能只是众多此类应用中的一个开端。

如何让这些新兴的智能体拥有更加旺盛的好奇心,不仅成为我们问题的解答者,更能主动抛出新的疑问,这将是未来我们面临的一项艰巨而有趣的挑战。在与ChatGPT进行了多次愉快的交流后,我愈发觉得,硅基伙伴的时代已经悄悄到来,未来,我们或许还将见证硅基合作者、教师,甚至诺贝尔奖获得者的诞生。